Πλήρως αυτοδίδακτη πλέον η AI της Google DeepMind

Η τεχνητή νοημοσύνη δεν σκέφτεται απλά μόνη της, πλέον μαθαίνει και μόνη της, άνευ… διδασκάλου. Η θυγατρική της Google, DeepMind, έκανε ακόμη ένα μεγάλο βήμα στον τομέα του AI (Artificial Intelligence): βρήκε και εφάρμοσε με επιτυχία τον τρόπο το αναβαθμισμένο «έξυπνο» σύστημά της AlphaGo Zero να διδάσκεται και μόνο του. Το σύστημα AI έγινε εξπέρ στο κινεζικό επιτραπέζιο παιγνίδι Go χωρίς καμία πλέον ανθρώπινη παρέμβαση! Έμαθε τα πάντα μόνο του εκ του μηδενός.

Το AlphaGo Zero χρειάσθηκε μόνο 40 μέρες για να αφομοιώσει γνώσεις 3.000 ετών και να γίνει ανίκητο στο συγκεκριμένο τρομερά απαιτητικό παιγνίδι.

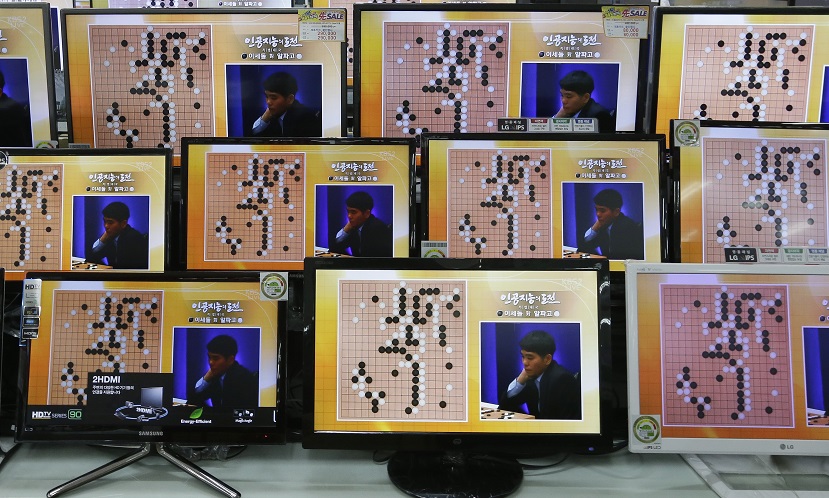

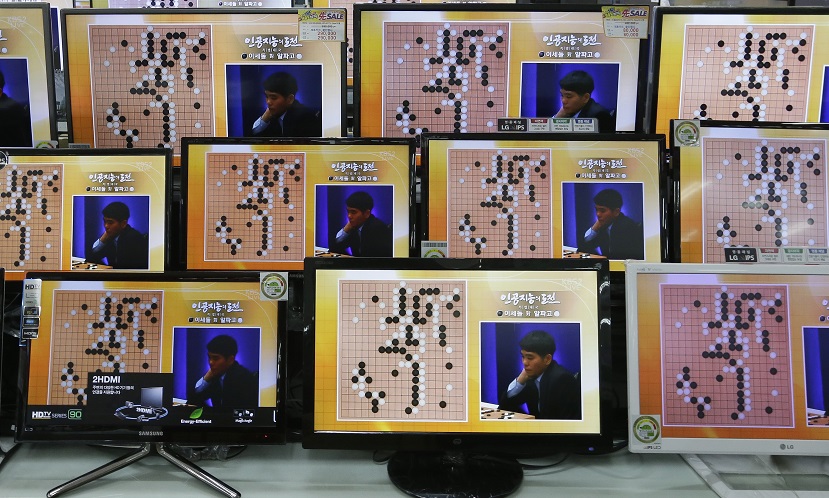

Το προηγούμενο πρόγραμμα τεχνητής νοημοσύνης AlphaGo είχε έως τώρα νικήσει άνετα δύο από τους καλύτερους στον κόσμο παίκτες του Go, αρχικά με 4-1 τον 18 φορές παγκόσμιο πρωταθλητή νοτιοκορεάτη Λι Σε-ντολ και μετά με 3-0 τον κινέζο παγκόσμιο πρωταθλητή Κε Τζίε. Αλλά, είχε προηγουμένως εκπαιδευθεί μελετώντας επί μήνες εκατομμύρια παιγνίδια από ανθρώπους «μάστερ» του εν λόγω παιγνιδιού.

Αυτή τη φορά, όμως, το νέο AlphaGo Zero ξεκίνησε χωρίς να έχει καμία άλλη ανθρώπινη εκπαίδευση, πέρα από τη γνώση των κανόνων του Go. Το νέο πρόγραμμα τεχνητής νοημοσύνης άρχισε να παίζει με τον εαυτό του για εξάσκηση και μέσα σε τρεις μέρες -αφού είχε παίξει σχεδόν πέντε εκατομμύρια παιγνίδια!- ήταν πια ικανό να νικήσει το προηγούμενο πρόγραμμα AlphaGo (τον νικητή των ανθρώπων) με σκορ 100-0! Μάλιστα, το σύστημα βρήκε μόνο του πρωτότυπες κινήσεις, που μέσα σε τόσες χιλιάδες χρόνια οι άνθρωποι δεν είχαν διανοηθεί ότι μπορούν να υπάρξουν και δεν είχαν ποτέ χρησιμοποιήσει στο παιγνίδι τους.

Περήφανος ο ιδρυτής και διευθύνων σύμβουλος της Google DeepMind, ο βρετανο-κύπριος Ντέμης Χασάμπης, δήλωσε ότι το νέο σύστημα, που είναι πλέον αποκλειστικός δάσκαλος του εαυτού του, μπορεί να έχει πολύ περισσότερες εφαρμογές. «Νομίζουμε ότι είναι πια αρκετά καλό για να πετύχει σημαντική πρόοδο σε μερικά πραγματικά προβλήματα, αν προφανώς απέχουμε ακόμη πολύ από μια πλήρη τεχνητή νοημοσύνη», τόνισε.

Οπως είπε ο βασικός ερευνητής Ντέιβιντ Σίλβερ, «το νέο σύστημα ξεκινά από ένα νευρωνικό δίκτυο που δεν ξέρει τίποτε απολύτως για το παιγνίδι του Go, πέρα από τους κανόνες του. Στη συνέχεια, τα μαθαίνει όλα παίζοντας παιγνίδια με τον εαυτό του».

Το αρχαίο κινεζικό παιγνίδι Go έχει μια ιστορία αρκετών χιλιάδων ετών. Αν και οι κανόνες του είναι πιο απλοί σχέση με του σκακιού, οι δύο παίκτες έχουν να επιλέξουν κάθε φορά ανάμεσα σε περίπου 200 κινήσεις έναντι περίπου 20 στο σκάκι.

Οι ερευνητές της DeepMind είναι ενθουσιασμένοι -αλλά κάποιοι άλλοι μάλλον φοβισμένοι- που το νέο σύστημα μέσα σε λίγες μέρες αφομοίωσε μόνο του γνώσεις και εμπειρίες, τις οποίες είχαν συσσωρεύσει οι άνθρωποι σε διάστημα χιλιάδων ετών.

Όπως είπε ο Σίλβερ, «στην πραγματικότητα ξεπεράσαμε τους περιορισμούς της ανθρώπινης γνώσης και το νέο σύστημα είναι ικανό να δημιουργήσει μόνο του γνώση, ξεκινώντας από κάποιες πρώτες αρχές, στην ουσία εκ του μηδενός». Μάλιστα το νέο σύστημα AlphaGo Zero δεν χρειάζεται για να «τρέξει» παρά έναν υπολογιστή με τέσσερις μόνο επεξεργαστές, έναντι 48 μονάδων επεξεργασίας που χρησιμοποιούσε ο προκάτοχός του AlphaGo.

Το επόμενο βήμα, σύμφωνα με τον Χασάμπη, θα είναι η αξιοποίηση του νέου συστήματος τεχνητής νοημοσύνης σε πεδία όπως η ανάπτυξη νέων φαρμάκων και νέων υλικών. «Ελπίζω», τόνισε, «ότι θα γίνουν ρουτίνα αυτού του είδους οι αλγόριθμοι, που θα συνεργάζονται μαζί με μας ως επιστημονικοί εμπειρογνώμονες ή ειδικοί στην ιατρική, προάγοντας έτσι τα σύνορα της επιστήμης και της ιατρικής».

Προς το παρόν πάντως, όπως επεσήμαναν άλλοι ειδικοί της τεχνητής νοημοσύνης, παρόλη την πρόοδο που έχει κάνει η DeepMind, το σύστημά της συνεχίζει να χρειάζεται έναν αρχικό προγραμματισμό από ανθρώπους, ενώ ασφαλώς κάθε άλλο παρά γενική εξυπνάδα διαθέτει.

Οι ερευνητές της Google DeepMind, με επικεφαλής τους Χασάμπη και Σλίβερ, έκαναν τη σχετική δημοσίευση στο περιοδικό "Nature". Στην ερευνητική ομάδα συμμετέχει και ο έλληνας μηχανικός λογισμικού Ιωάννης Αντώνογλου, ο οποίος αποφοίτησε από το Τμήμα Ηλεκτρολόγων Μηχανικών και Μηχανικών Η/Υ του Αριστοτελείου Πανεπιστημίου Θεσσαλονίκης το 2011, έκανε μεταπτυχιακά στην τεχνητή νοημοσύνη στο Πανεπιστήμιο του Εδιμβούργου και από το 2012 εργάζεται στη Google Deep Mind.